更换图床地址

This commit is contained in:

@@ -6,20 +6,20 @@ date = "2025-03-26"

|

||||

description = "又到一个大玩具"

|

||||

categories = ["Consumer", "Linux"]

|

||||

tags = ["DeepSeek", "Nvidia"]

|

||||

image = "https://img.mitsea.com/blog/posts/2025/03/%E6%9C%AC%E5%9C%B0%E9%83%A8%E7%BD%B2%20DeepSeek-V3-0324/HGX%20H200%20Tech%20Blog.avif"

|

||||

image = "https://hf-index.mitsea.com:8840/d/Share/mitsea-public-source/blog/posts/2025/03/%E6%9C%AC%E5%9C%B0%E9%83%A8%E7%BD%B2%20DeepSeek-V3-0324/HGX%20H200%20Tech%20Blog.avif"

|

||||

+++

|

||||

|

||||

## 前言

|

||||

|

||||

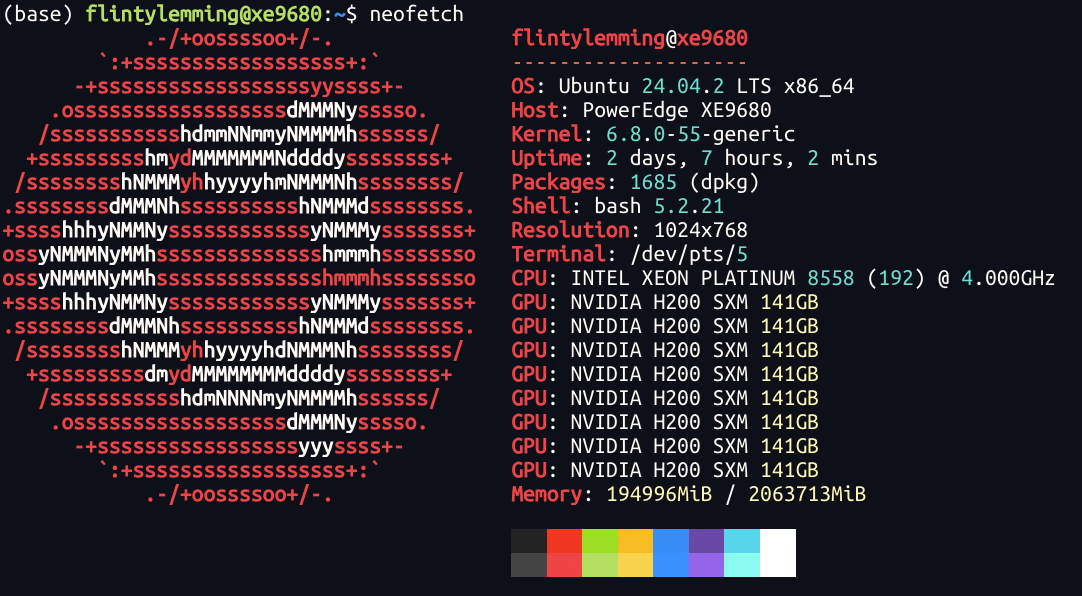

继先前的 [Dell R750xa + A6000](https://blog.mitsea.com/d29bb28b14984443b232263348b946ba/) 后,又到了个大玩具,事 Dell XE9680 + H200.jpg

|

||||

|

||||

|

||||

|

||||

|

||||

机器到了有段时间了,但之所以拖到现在写(水)文章是因为目前开源推理框架对于 DeepSeek 终于算是可用了,特别是在 128k 上下文这块。所以这篇文章虽然看着非常水,但先前也是与 vLLM 和 SGLang 斗智斗勇了数个深夜。

|

||||

|

||||

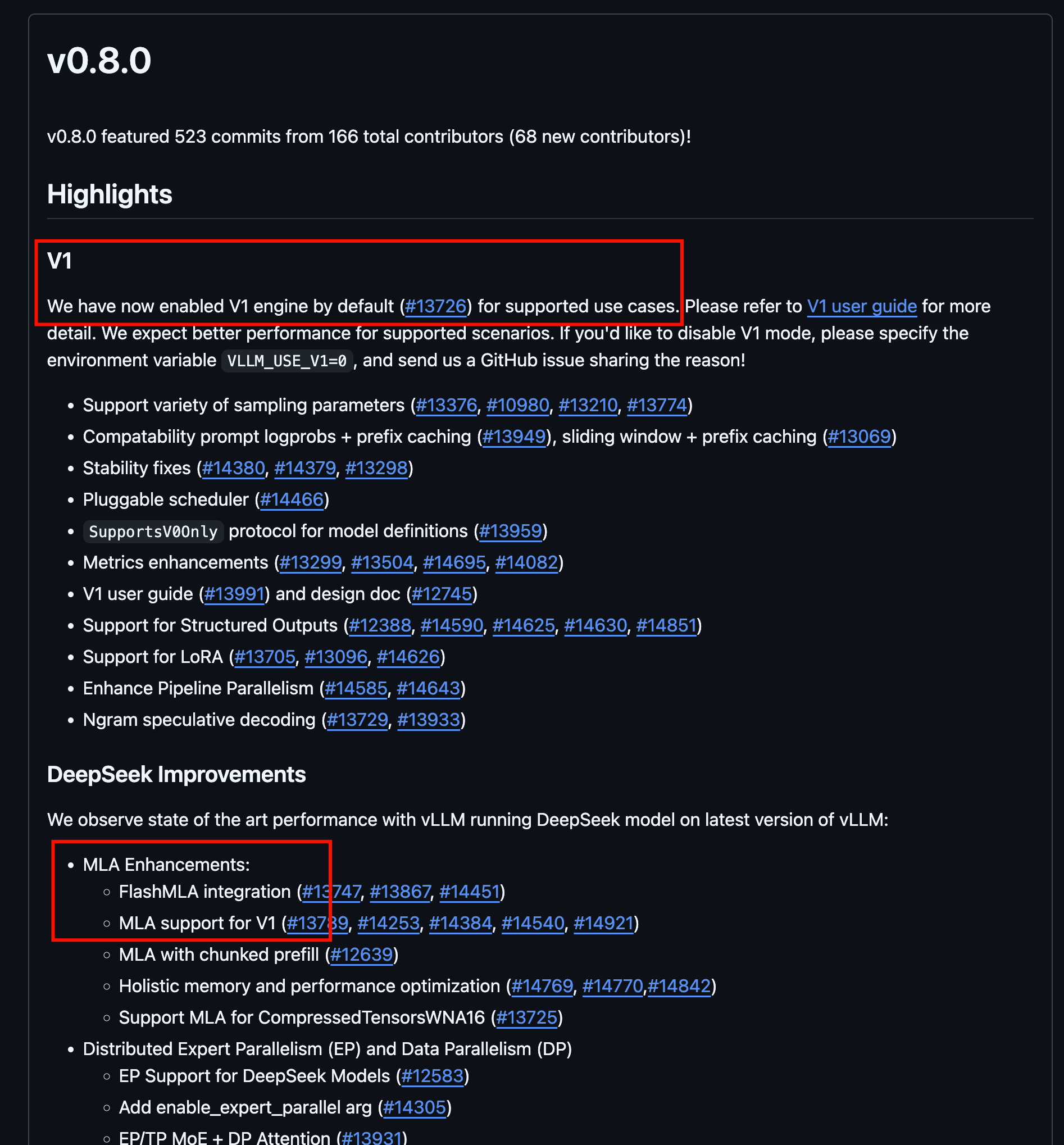

目前的关键更新是 vLLM 在 0.8 版本中对于 DeepSeek 推理默认使用 v1 版本的分支了,所以推理后端默认开始使用 FlashMLA 了,这有效解决了先前 vLLM 使用 TritonMLA 后端导致莫名的上下文不能超过 32k。

|

||||

|

||||

|

||||

|

||||

|

||||

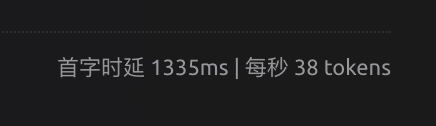

至于 SGLang,在使用 EP + FlashMLA 时,如果提示词比较大(比如 70k),那解码会非常缓慢,这导致等待首字可能长达两分钟,原因未知。不过 SGLang 感觉好像也是主要搞 AMD ROCm 推理的,我们这 CUDA 就不凑热闹了。

|

||||

|

||||

@@ -62,12 +62,12 @@ vLLM 1.0 的逻辑会改成 SGLang 那种,就是推荐你用 Docker 安装,

|

||||

|

||||

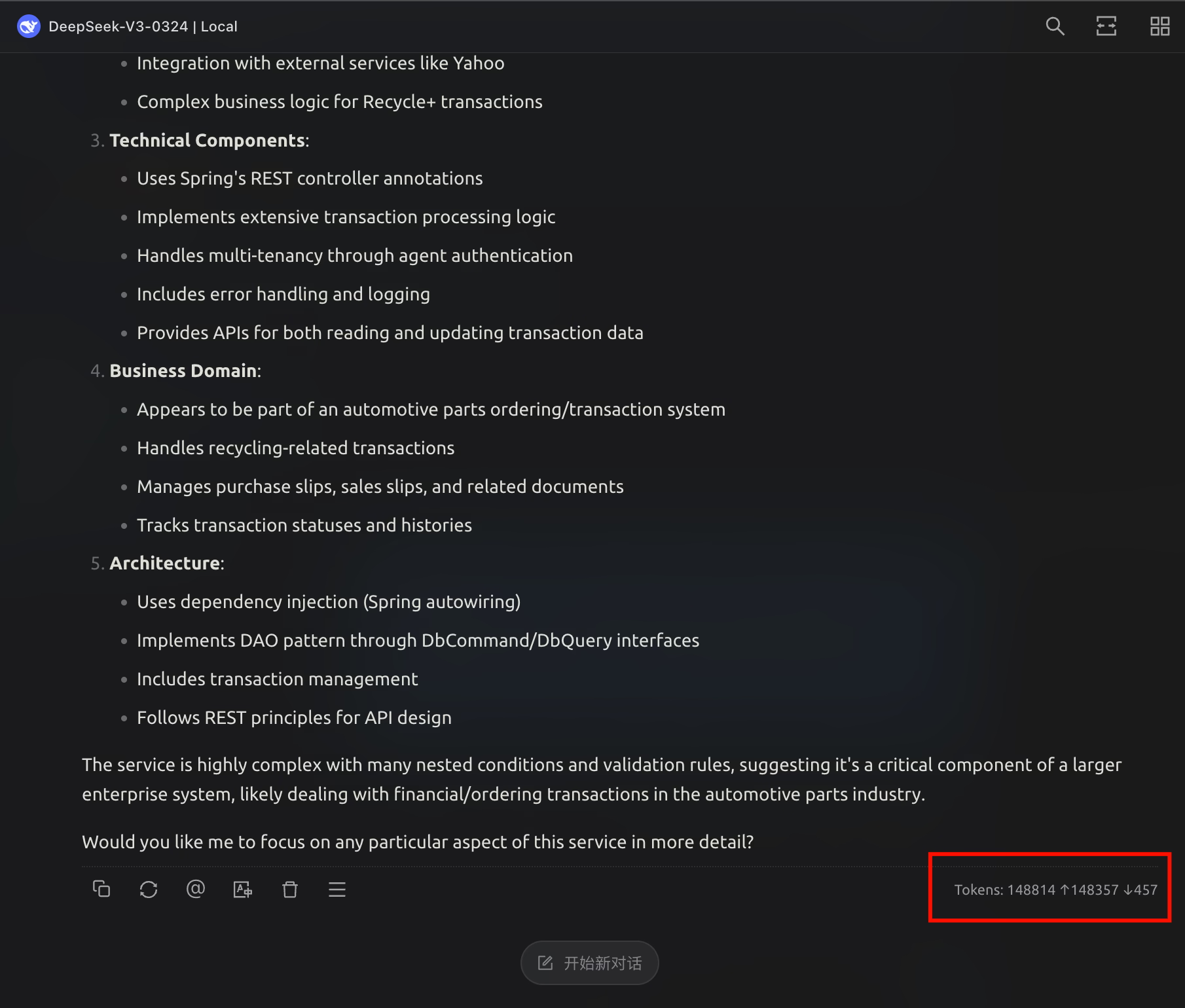

可以看到 128k 上下文毫无压力.jpg

|

||||

|

||||

|

||||

|

||||

|

||||

这么长的上下文,速度也是非常不错,比 SGLang 快多了

|

||||

|

||||

|

||||

|

||||

|

||||

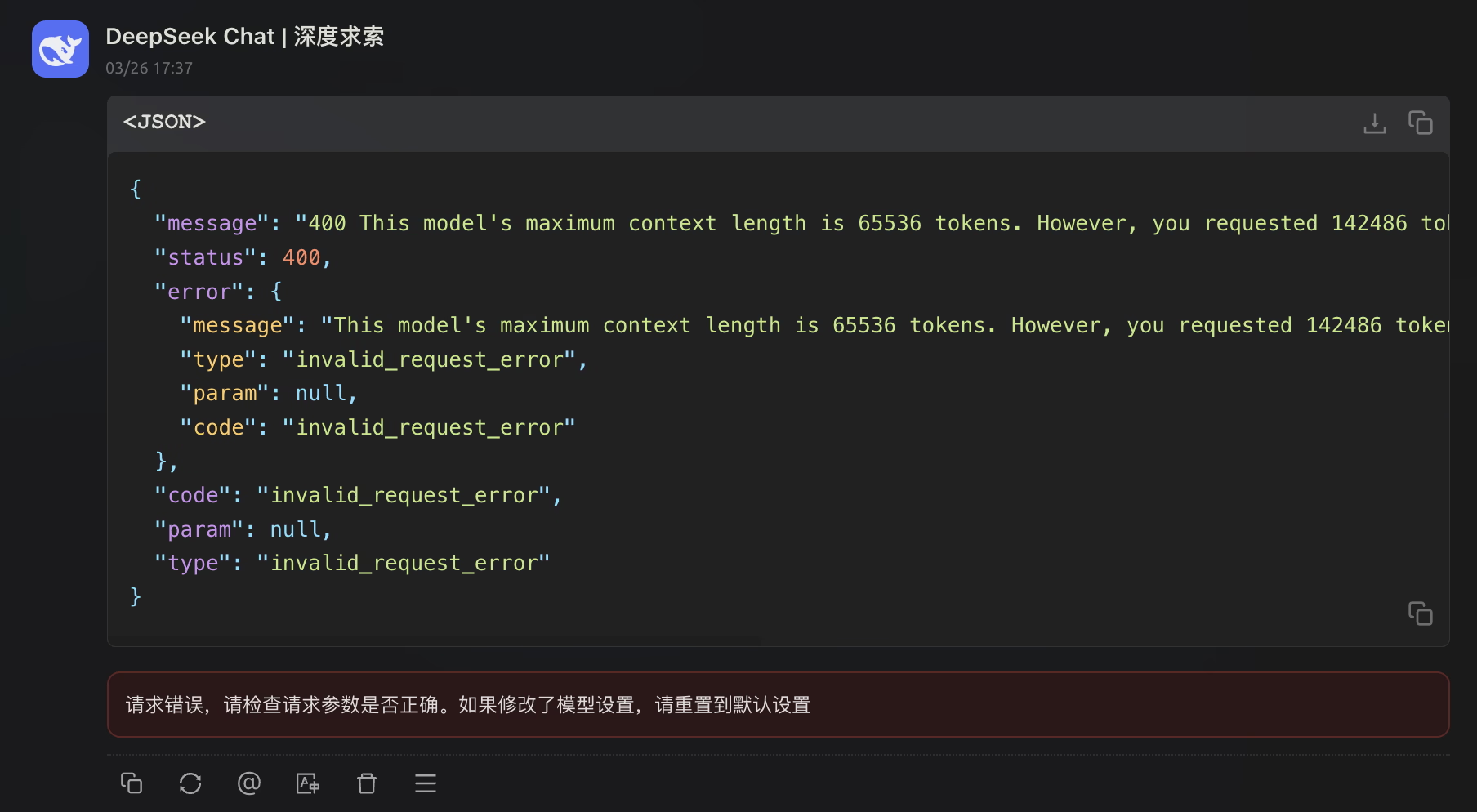

官方 API 目前还是 64k 上下文,这下秒杀官方了.jpg

|

||||

|

||||

|

||||

|

||||

Reference in New Issue

Block a user